Es el año de la inteligencia artificial. Con el 2023, entramos en el «momentum» en el que las diversas formas de A.I. se han vuelto pop y mainstream, ya no como tema de especialistas, geeks y atentos al mundo tecnológico, sino como tema de editoriales, artículos de moda, un impacto concreto en nuestras vidas.

Y las instituciones se están moviendo en el tema. Como señaló Mit Technology Rewiev, veremos cómo el panorama regulatorio de la IA pasa de pautas éticas vagas y generales a regulaciones concretas. Los legisladores de la Unión Europea en la UE, están finalizando una serie de reglas y las agencias gubernamentales de EE. UU., como la Comisión Federal de Comercio, también están redactando nuevos marcos legales.

Los legisladores en Europa están trabajando en reglas para modelos de IA que producen imágenes y texto, como Stable Diffusion, LaMDA y ChatGPT. Reglas que podrían señalar el final de la era de las empresas que lanzan sus modelos de IA con total libertad, o con poca (o ninguna) protección o responsabilidad.

Los modelos mencionados anteriormente, forman cada vez más la columna vertebral de muchas aplicaciones de IA. Sin embargo, las empresas que los crean siguen «abotonadas» sobre cómo se construyen y entrenan estas aplicaciones. De hecho, no sabemos mucho sobre cómo funcionan, lo que dificulta entender cómo los modelos generan contenido dañino o resultados distorsionados, y mucho menos cómo mitigar estos problemas.

La Unión Europea planea actualizar su próxima regulación de inteligencia artificial, llamada A.I. Act, con reglas que obligan a las empresas a arrojar luz sobre el funcionamiento interno de sus modelos de IA. Es probable que el reglamento se apruebe en la segunda mitad del año y, después de eso, las empresas tendrán que cumplirlo, si quieren vender o usar productos de IA en la UE o enfrentar multas de hasta el 6% de su facturación mundial anual total. .

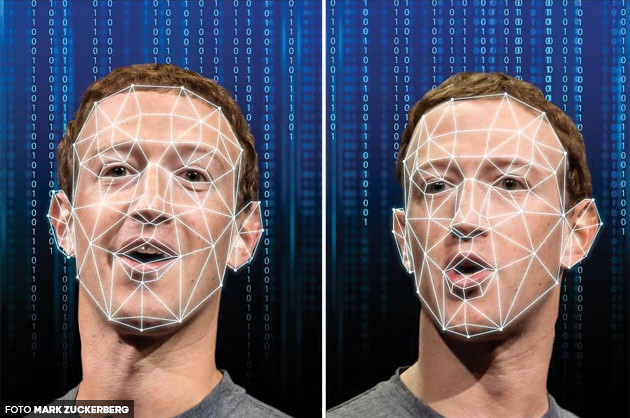

La UE llama a estos modelos generativos “sistemas genéricos de inteligencia artificial”, porque se pueden utilizar para muchas cosas diferentes (que no deben confundirse con la inteligencia artificial general). Por ejemplo, los modelos de lenguaje grande como GPT-3 se pueden usar en chatbots de servicio al cliente o para crear desinformación a gran escala, Stable Diffusion se puede usar para crear imágenes para tarjetas de felicitación o pornografía profunda no consensuada.

“Si bien todavía se debate con vigorosamente cómo se regularán exactamente estos modelos en la Ley de IA, los modeladores genéricos de IA, como OpenAI, Google y DeepMind, probablemente necesitarán ser más abiertos sobre cómo se construyen y entrenan los modelos”. dice Dragoș Tudorache, miembro del Parlamento Europeo que forma parte del equipo que trabaja en la ley de IA.

Regular estas tecnologías es complicado, porque hay dos conjuntos diferentes de problemas asociados con los modelos generativos, con soluciones políticas muy diferentes, dice Alex Engler, investigador de gobernanza de IA en la Institución Brookings. Uno es la difusión de contenido dañino generado por IA, como el discurso de odio y la pornografía no consentida, y el otro es la perspectiva de resultados sesgados cuando las empresas integran estos modelos de IA en su contratación, o los usan para revisar documentos legales.

Engler sugiere que los creadores de modelos generativos deberían estar obligados a crear restricciones sobre qué modelos producirán, monitorear sus resultados y bloquear a los usuarios que abusan de la tecnología.

El impulso actual de los reguladores por una mayor transparencia y responsabilidad corporativa, podría marcar el comienzo de una nueva era en la que el desarrollo de la IA sea menos explotador y se realice de una manera que respete derechos, como el de privacidad.